Erwartungsgemäß hat Nvidia auf der noch laufenden GTC 2024 (GPU Technology Conference) in der Nacht von Montag auf Dienstag die neue Blackwell-Architektur vorgestellt, die verspricht, neue Maßstäbe zu setzen.

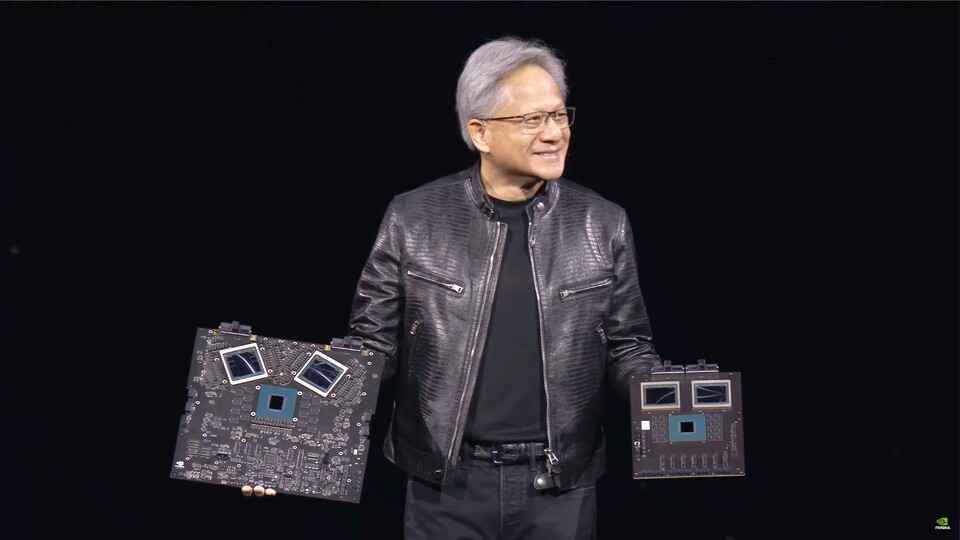

Wie Nvidia-CEO Jensen Huang dazu passend erklärte, soll diese eine »neue Ära generativer KI« einläuten. An der Speerspitze steht hierbei der B200-Chip, der die bisherigen H100- und GH100-Flaggschiffe aus der Hopper-Generation ablöst.

Die beeindruckenden technischen Eckdaten (siehe unten) legen dabei nahe, dass Großkunden wie Amazon und Microsoft mit entsprechendem Bedarf und Budget bei Nvidia Schlange stehen werden, um so viele dieser Chips wie möglich zu bekommen.

Das Wichtigste in Kürze

- Nvidia präsentiert auf der GTC 2024 die neue Blackwell-Architektur für generative KI.

- Der B200-Chip löst die H100- und GH100-Flaggschiffe ab und bietet eine verbesserte Leistung und Energieeffizienz.

- Die GPU basiert auf einem 4-nm-Fertigungsprozess und verfügt über 208 Milliarden Transistoren.

- Der GB200-Superchip kombiniert Grace-Prozessoren, Blackwell-GPUs und bietet extrem hohe Rechenleistung.

Technische Daten des Nvidia B200

Die GPU wird auf Basis des 4NP-Fertigungsprozesses entwickelt - also einer speziellen auf Blackwell ausgelegten 4-nm-Fertigung des taiwanesischen Chipherstellers TSMC.

Beim B200 selbst handelt es sich um ein Dual-Die-Design. Die beiden verbauten Chips kommunizieren via Dia-to-Die-Link mit einer Geschwindigkeit von bis zu 10 TByte pro Sekunde und sollen so gegenüber dem MCM-Verfahren (Multi Chip Module), das primär von AMD eingesetzt wird, keinerlei Nachteile aufweisen.

Link zum YouTube-Inhalt

Insgesamt liegen so 208 Milliarden Transistoren in der B200-Karte vor. Die theoretischen Rechenleistungen äußern sich Nvidia zufolge wie folgt:

- FP8: Bis zu 20 PetaFLOPS

- FP16: Bis zu 10 PetaFLOPS

- FP32: Bis zu 5 PetaFLOPS

Daraus soll laut Huang eine etwa vierfache Leistung beim KI-Training sowie eine 30-fache Performance bei der KI-Inferenz entstehen. Die Energieeffizienz soll indes um den Faktor 25 verbessert werden.

Speicherseitig arbeitet Nvidia B200 mit 192 GByte HBM3e-Speicher, die Bandbreite soll bei bis zu 8 TByte/s liegen.

»Grace Blackwell« als neuer Superchip

Der neue Chip bildet auch die Grundlage für den GB200 genannten »Grace Blackwell«-Superchip, der primär in dem Nvidia-eigenen NVL72-Computer sowie kundenspezifischen Lösungen zum Einsatz kommen soll.

Namensgetreu handelt es sich bei GB200 Grace Blackwell um eine Hybridlösung bestehend aus einem Grace-Prozessor mit 72 Neoverse-V2-Kernen des Herstellers Arm sowie zwei der gezeigten B200-Grafikchips - damit verfügt ein einzelner GB200-Chip in dieser Hinsicht über vier Dies.

Im erwähnten NVL72-Computer werden gleich 36 der Grace-CPUs mitsamt 72 Blackwell-GPUs (und daraus folgend 144 Blackwell-Dies) genutzt, was sich in folgenden wahnwitzigen technischen Daten äußert:

- Prozessor: 2.592 ARM Neoverse V2 Kerne

- Arbeitsspeicher: Bis zu 17 TByte LPDDR5X-RAM

- 72 Blackwell-GPUs mit 13,5 TByte HBM3e-Speicher

- FP4-Rechenleistung: Bis zu 1.440 PetaFLOPS

- FP8-Rechenleistung: Bis zu 720 PetaFLOPS

- FP16-Rechenleistung: Bis zu 360 PetaFLOPS

Dank NVLink, welches bis zu 130 TByte pro Sekunde an Bandbreite verspricht, soll sich der NVL72-Supercomputer wie ein einziger massiver Grafikprozessor verhalten.

Insgesamt lassen sich in einer solchen NVLink-Domain bis zu 576 GPUs miteinander verbinden - die gesamte Rechenkraft solle Huang zufolge dafür ausreichen, Large Language Models (LLMs) mit Billionen an Parametern zu verarbeiten.

Die vorausgesetzte Leistungsaufnahme ist entsprechend hoch: Ein einzelner GB200-Superchip soll bis zu 2.700 Watt benötigen.

Die ersten Geschäftskunden stehen schon Schlange

Im Laufe des Jahres soll die KI-Plattform für Geschäftspartner zur Verfügung stehen.

Explizit nennt Nvidia hier Cloud-Anbieter wie AWS, Google Cloud, Microsoft Azure und Oracle Cloud Infrastructure, die wenig überraschend Interesse an der Blackwell-Architektur zeigen. Wie Huang erklärt, stehe Nvidia mit Blackwell so vor dem »erfolgreichsten Launch der Firmengeschichte«.

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.