Raytracing per Hardware - Hybrid-Rendering, RT-Cores und Deep Learning

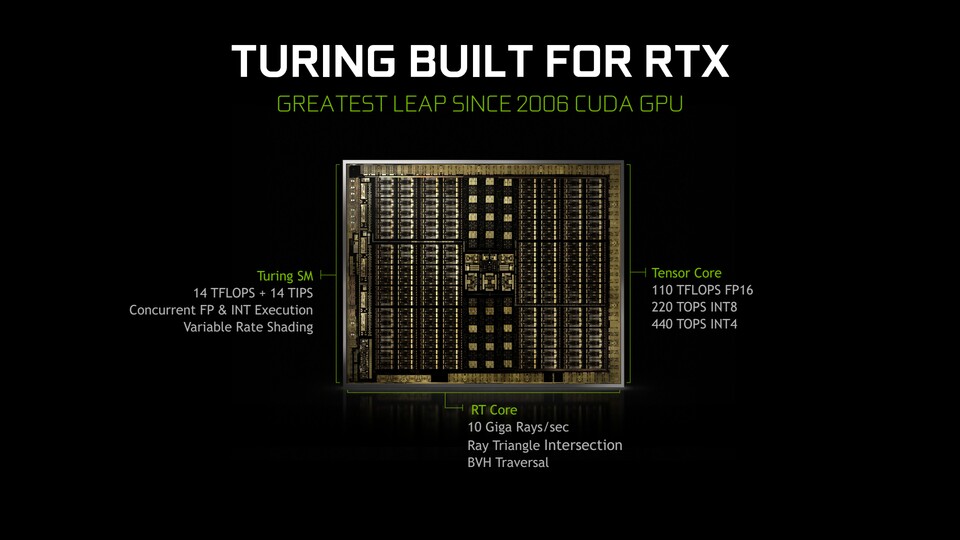

Die neue Turing-Architektur von Nvidia ist speziell auf das Echtzeit-Raytracing ausgelegt. Eine ihrer wichtigen Neuerungen besteht dementsprechend in speziellen Recheneinheiten, die nur dazu da sind, das Raytracing zu beschleunigen. Nvidia nennt sie wenig überraschend »Raytracing-Cores« (beziehungsweise »RT-Cores«).

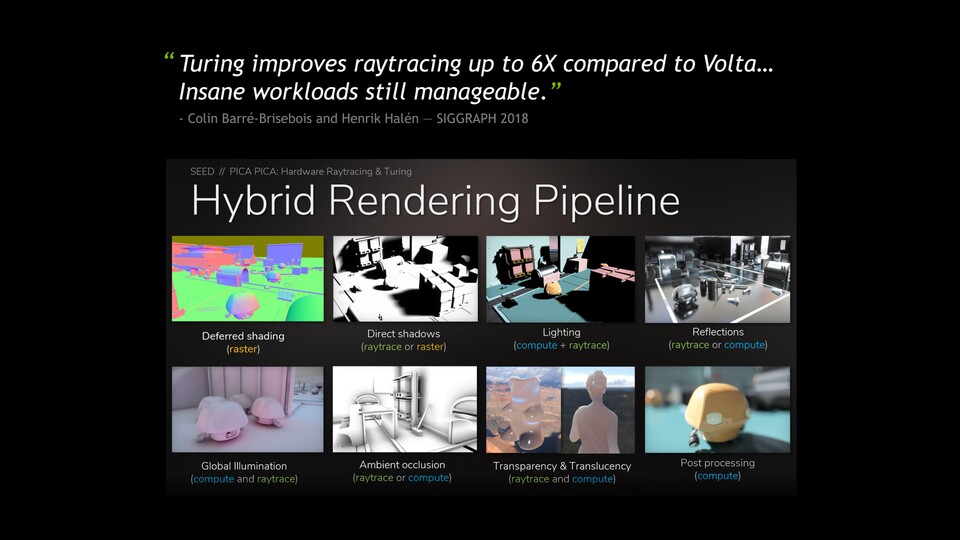

Außerdem ein sehr wichtiger Faktor: Raytracing soll zunächst per »RTX Hybrid Rendering« in Spielen Einzug halten. Das bedeutet, dass die Berechnung des Bildes mit einer Kombination aus klassischer Rasterisierung und Raytracing erfolgt. So soll Raytracing beispielsweise in Shadow of the Tomb Raider zunächst nur in Hinblick auf die realistische (und damit unter anderem weichere) Darstellung von Schatten genutzt werden.

Bei der Gamescom-Präsentation sagte Jensen Huang, dass die Raytracing-Berechnung ohne die neuen RT-Cores zehnmal so lange dauern würde. Dazu passend liefert er auch einen neuen Wert für die Messung der Raytracing-Performance, genauer gesagt die so genannten »Giga Rays per Second«.

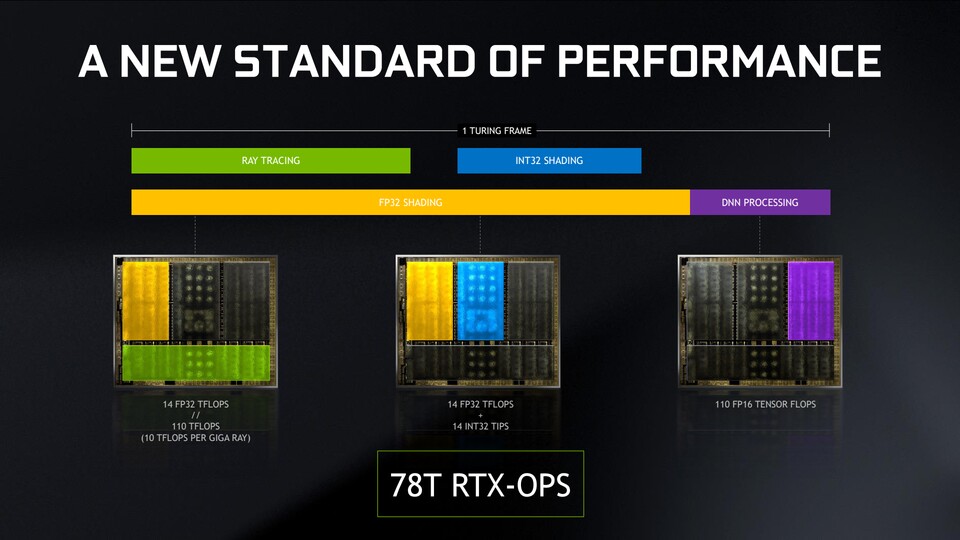

Während das Flaggschiff der GTX-1000-Generation Geforce GTX 1080 Ti laut Jensen auf 1,21 Giga Rays (ohne spezielle RT-Einheiten) pro Sekunde kommt, sind mit der neuen Turing-Architektur 10 Giga Rays pro Sekunde möglich. Außerdem kann die Berechnung des Bildes per Deep Learning-Algorithmus ergänzt werden, wofür bei Turing die neuen »Tensor-Cores« vorhanden sind.

Vereinfacht ausgedrückt soll der Algorithmus die korrekte Farbgebung von Pixeln ermöglichen, die noch nicht oder nicht korrekt im regulären Render-Vorgang erfasst wurden. Das bezeichnet Nvidia als »DNN-Processing«, wobei die Abkürzung für »Deep Neural Network« steht. Darüber könnte beispielsweise das beim Raytracing häufig auftretende Problem des Bildrauschens behoben oder zumindest gelindert werden, das entsteht, wenn nicht genug Strahlen zur Erfassung von Bildinformationen ausgesendet werden.

Auch in diesem Fall hat Jensen einen Leistungsvergleich zu der Vorgänger-Generation Pascal parat: Die Tensor-Cores von Turing sollen KI-Berechnungen ermöglichen, für die man zehn Geforce GTX 1080 Ti benötigen würde, die nicht über diese speziellen Recheneinheiten verfügen.

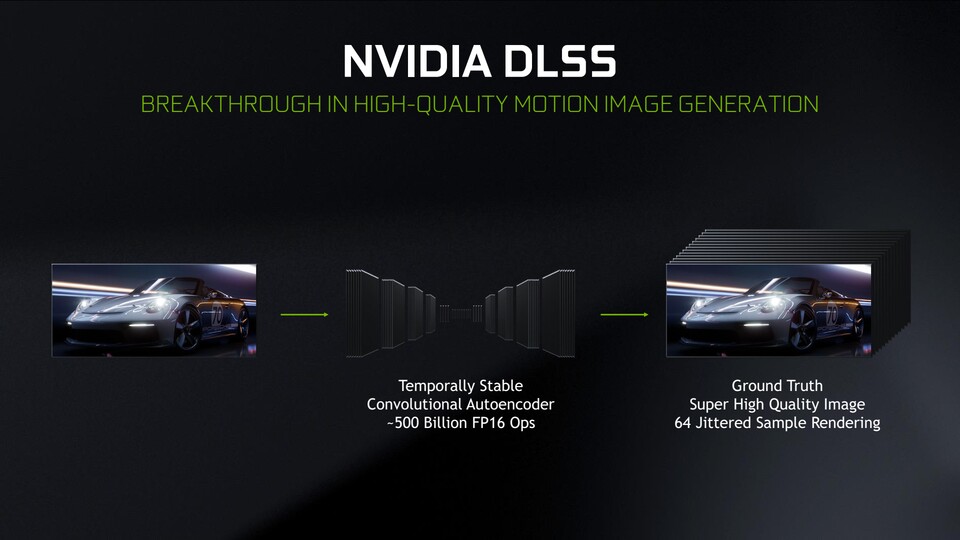

Ein weiterer Einsatzzweck der Tensor-Cores besteht unabhängig von Raytracing: Das neue »DLSS« (steht für »Deep Learning Super-Sampling«). Dabei wird ein KI-Algorithmus angewendet, der zuvor auf einem Supercomputer darauf trainiert wurde, die Bildqualität eines Frames anhand zuvor erlernter Beispiele automatisch zu erhöhen.

Das kann sich beispielsweise in Form von einer sehr guten Kantenglättung äußern, ohne gleichzeitig ein unschärferes Bild oder Artefakte wie bei anderen Glättungs-Methoden wie FXAA oder TAA hinnehmen zu müssen.

Was es bringt - und was es kostet

Im besten Fall führt Raytracing zu einer authentischeren Darstellung von Spielen, indem unter anderem alle vorhandenen Lichtquellen physikalisch korrekt berücksichtigt werden, Schattenwürfe weich und echt aussehen und Reflexionen Objekte so widerspiegeln, wie wir das von der realen Welt gewohnt sind.

Die ersten Demos von der Gamescom lassen allerdings bereits vermuten, dass es noch so manchen Stolperstein auf dem Weg in die schöne, neue Raytracing-Welt gibt. Einer davon ist der erwartungsgemäß große Leistungshunger, der sich etwa am Beispiel von Shadow of the Tomb Raider andeutet. Ein Video zeigt, dass selbst das neue Flaggschiff Geforce RTX 2080 Ti das Spiel mit aktivierten »Raytraced Shadows« in vielen Szenen nur mit 30 bis 40 darstellen konnte - und zwar in Full HD.

Unseres Wissens nach liefen alle Raytracing-Demos auf der Gamescom in dieser Auflösung, was dafür spricht, dass der Performance-Hunger von Raytracing in 4K-Auflösung mit der vierfachen Pixelmenge im Vergleich zu Full HD endgültig zu viel des Guten gewesen wäre. Allerdings sind weder die gezeigten Spiele noch die RTX-2000-Karten respektive deren Treiber schon veröffentlicht.

Etwas Zeit für Optimierungen ist also noch vorhanden. Außerdem wird man Raytracing voraussichtlich separat ein- und ausschalten können. Es sollte also möglich sein, für eine bessere Performance auf Wunsch darauf zu verzichten.

Eine Möglichkeit, Ressourcen beim Raytracing zu schonen, dürfte darin bestehen, weniger Strahlen zu verfolgen - und sie weniger weit zu verfolgen. Das hat aber wiederum Einfluss auf die Darstellungsqualität. Solche Kompromisse werden aber vermutlich auch mit Nvidias neuen Geforce-RTX-2000-Karten noch länger unumgänglich sein, wenn die Zahl der Bilder pro Sekunde beim Echtzeit-Raytracing stimmen soll.

Die Technik hat unabhängig davon durchaus das Potenzial, die Darstellung von Computerspielen deutlich zu verbessern. Eine wirklich neue Erkenntnis ist das aber nicht. Gleichzeitig wird sich wohl erst anhand von Testexemplaren der neuen RTX-Grafikkarten samt passender Raytracing-Spiele zeigen, wie groß der Fortschritt wirklich ist, den Nvidia in dieser Hinsicht mit Turing erzielt hat.

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.